«I dati che abbiamo a disposizione spesso sono rappresentativi di un pregiudizio o comunque di una storia che non è stata equa nei confronti di alcune porzioni di popolazione». In questo modo Chiara Criscuolo, ricercatrice del Dipartimento di Elettronica, Informazione e Bioingegneria del Politecnico di Milano, ci spiega come la enorme mole di dati che abbiamo e usiamo, anche per prendere decisioni automatizzate, possono nascondere una discriminazione. Noi di frontiere l’abbiamo incontrata per capire meglio cos’è la Data Science Ethics.

Come è iniziato il tuo percorso di ricerca qui al Politecnico?

Dopo una triennale in ingegneria informatica mi sono iscritta al percorso di laurea magistrale in Computer Science Engineering. La laurea è arrivata con il Covid, quindi ero un po’ disorientata nel trovare un lavoro fuori dall’università. La mia professoressa Letizia Tanca mi ha chiesto se volessi restare a fare ricerca in dipartimento, con un assegno di ricerca. Sono quindi rimasta al Politecnico per due anni, lavorando prima a un progetto europeo che coinvolge gli istituti di ricerca (IRCCS) di tutta Italia, occupandomi della parte etica di questo progetto, che ha come scopo quello di integrare i database di tutti gli ospedali, per fare ricerca in comune. Un esempio potrebbe essere quello di raccogliere i dati sul tumore al polmone, per studiare se il modello predittivo o l’analisi utilizzata per fare la predizione di questo tumore sarà più precisa se condivisa.

Dopo il primo anno di ricerca sono entrata in un altro progetto, ICT4DEV, un programma del Politecnico di Milano in collaborazione con l’università Eduardo Mondlane di Maputo (UEM), e AICS (Agenzia Italiana per la Cooperazione allo Sviluppo) coordinato dal Prof. Luciano Baresi. ICT4DEV affronta alcune delle tematiche legate allo sviluppo delle Information and Communication Technology (ICT) in Mozambico, rispondendo ai bisogni formativi e di skill building in un settore che si sta evolvendo velocemente e supportando lo sviluppo delle applicazioni ICT nei settori a maggior impatto per lo sviluppo sociale ed economico del Paese. Lo sviluppo sostenibile è perseguito attraverso la formazione di specialisti ICT e il sostegno alla creazione di un ambiente culturale che valorizzi l’uso delle ICT.

E cosa hai approfondito con il tuo dottorato di ricerca?

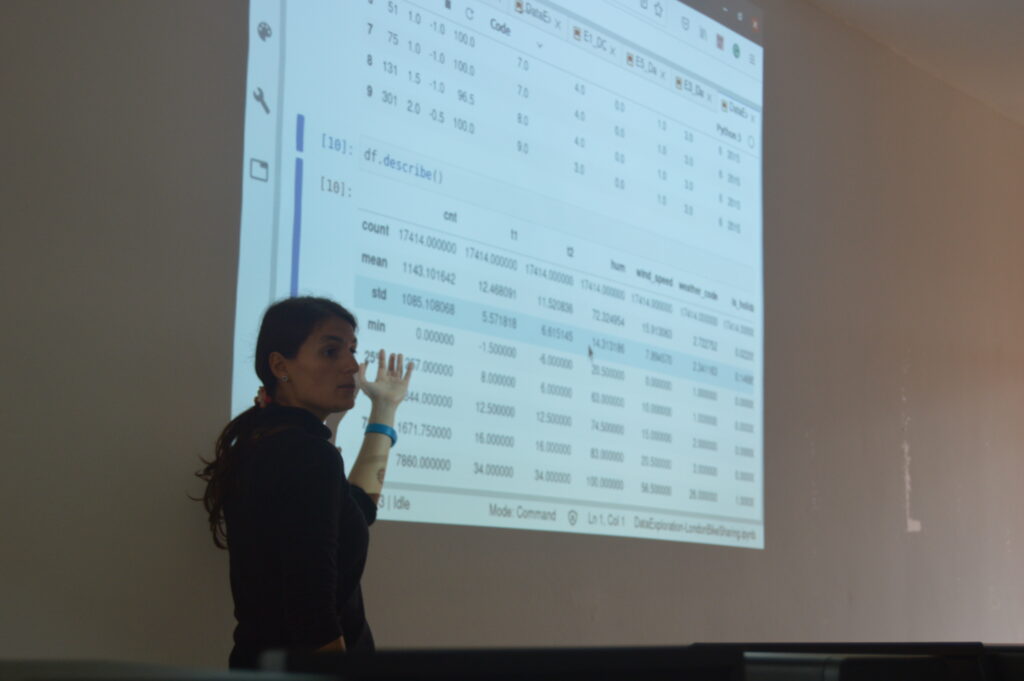

Dopo due anni di assegno di ricerca ho iniziato il dottorato di ricerca, che continuava la mia ricerca iniziata con la tesi magistrale e proseguita nel corso degli anni, parallelamente ai progetti di ricerca. La mia tesi magistrale si intitolava FairDB – Using Functional Dependencies to discover Data Bias: basata su tecniche provenienti dalle aree di Database e Data Mining, concentrata nel campo della Data Science Ethics: in particolare, lo scopo è stato quello di rilevare un bias esistente nei set di dati attraverso le dipendenze funzionali. In altre parole, i dati che abbiamo a disposizione spesso sono rappresentativi di un pregiudizio o comunque di una storia che non è stata equa nei confronti di alcune porzioni di popolazione, e lo scopo è identificare queste discriminazioni tramite le tecniche offerte dal Data Mining e dei Database.

Quali ad esempio?

Le donne, le persone di colore, i nativi americani negli Usa, le minoranze in generale. Tramite i sistemi di machine learning otteniamo modelli usati quotidianamente per fare decisioni, scelte che impattano la vita delle persone, come quale stipendio dare a un dipendente o se assumere o meno un candidato. Se l’insieme di dati su cui facciamo “l’addestramento” del modello è biased, cioè contiene dei bias, questi pregiudizi vengono appresi dal modello e le decisioni che ne risultano sono discriminanti verso un gruppo di persone. Tutto diventa ancora più critico nel momento in cui il sistema è completamente automatico, cioè la decisione viene presa senza un umano, senza la consapevolezza dei rischi e questo è un problema.

Come è proseguita la tua ricerca?

Gli ultimi due anni ho lavorato su dataset economici, approfondendo il tema delle discriminazioni riguardanti il salario. Purtroppo, lo stereotipo può risiedere nei dati, o nell’algoritmo nel modello o nel decisore stesso. Quindi ogni piccolo passaggio ha la sua “responsabilità”. Se i dati di partenza sono stereotipati, l’algoritmo apprende un bias e se il decisore, che non è consapevole di questo, o peggio, lascia la scelta al sistema, va ad automatizzare un processo che prende decisioni sbagliate, quello che si ottiene è un feedback loop negativo dove si perpetra la discriminazione in maniera automatica senza rendercene conto.

Ora sto lavorando anche su dataset medici per capire se ci sono problematiche anche in questo campo. Il campo della salute è ancora più delicato, perché nel contesto medico emergono tutte le nostre diversità: ad esempio un tumore alla pelle è molto più facile da identificare tramite un sistema di machine learning o image recognition. Ed è più facile riconoscerlo su chi ha la pelle di colore chiaro. Quello che mi piacerebbe fare è un sistema che rende consapevole l’utente sul reale potenziale di rischio di errori o inesattezze che un sistema di machine learning ha in questo settore, perché tutto avviene in maniera automatica.

Come è iniziato questo interesse verso l’etica dei dati?

Volevo studiare filosofia all’università, ma mi dicevano che non fossi bravissima a scrivere; quindi, ho iniziato ingegneria perché forse matematica mi riusciva meglio e non avevo mai fatto informatica alle superiori e volevo cimentarmi in questa nuova esperienza. Qui al Politecnico ho frequentato i corsi di philosophical issues of computer science e Computer Ethics della professoressa Viola Schiaffonati. Questo corso mi ha permesso di ragionare su cosa voglia dire avere dati etici, cosa vuol dire che un dataset sia equo nei confronti delle popolazioni meno rappresentative, un dataset che non sia discriminatorio. Tutto questo grazie ai miei colleghi e ai professori del Politecnico, che mi hanno permesso di lavorare in un bel clima, sia di ricerca che umano.

Fino adesso hai preso in esame principalmente dati riguardanti gli Stati Uniti. L’ipotesi di provare a studiare dei dati europei o italiani è più complicata? È difficile reperirli?

Esatto, è difficile reperirli. Quello che si tende a fare ora poi è togliere le caratteristiche protette per privacy e ciò rende ancora più difficile identificare la discriminazione. Mi piacerebbe molto studiarli, spero appunto che collaborando con gli IRCSS italiani tramite il progetto medico di averne di più, ma per ora anche sul progetto sanitario è un po’ difficile.

Secondo te che impatto concreto può avere questa tua ricerca sulla società?

Non sono un legislatore, non posso fare leggi. Però quello che posso fare è creare uno strumento che mostri questo problema di discriminazione nei sistemi di machine learning, crei consapevolezza in chi lo usa e provi a correggere questo modello, perché nel momento in cui sono consapevole che donne e uomini vengono pagate diversamente, che persone di diversa etnia hanno trattamenti diversi, che il tumore al polmone sia distribuito diversamente nella popolazione, il decision maker può agire. Sfortunatamente la legge è l’ultima cosa che arriva. Secondo me quello che oggi posso fare io quindi è creare consapevolezza.